2024年7月にリリースされた GPTシリーズの最新モデル GPT-4o mini は、自然言語処理の精度が向上した、より自然で人間らしい対話が可能なモデルです。

Microsoft GPT-4 と同等の性能を持ちながら、GPT-4o の約1/30 の料金で利用できます。また、出力トークンに関しても 16000 トークンの出力ができるため、一度で大きな出力が可能という特徴があります。

実際に GPT-4o mini を Azure OpenAI で使用してみました。

GPT-4o mini と GPT-4o の性能比較

| 特徴 | GPT-4o mini | GPT-4o |

|---|---|---|

| 性能 | 高性能 GPT-4程度 | 最高性能 |

| 100万トークンあたりのコスト (入力/出力) | $0.15/$0.60 | $5.00/$15.00 |

| 最大入力トークン | 128Kトークン | 128Kトークン |

| 最大出力トークン | 16Kトークン | 4Kトークン |

| 対応コンテンツ | ・テキスト ・画像 (拡張予定) | ・テキスト ・画像 ・音声 ・動画 |

GPT-4o は複雑な作業や高度な分析に長けており、動画や音声が扱えるという点で 4o-mini に勝っています。一方、GPT-4o mini はリアルタイム応答や高頻度な API 呼び出しに適しており、コストの面では GPT-4o より圧倒的に経済的であり、単純作業に向いています。

GPT-4o mini を Azure OpenAI で使用する手順

1.Azure にてリソースグループを作成します。

2.作成したリソースグループを展開し、左上の [作成] を選択します。

3.Azure OpenAI を選択し、[作成] を選択します。

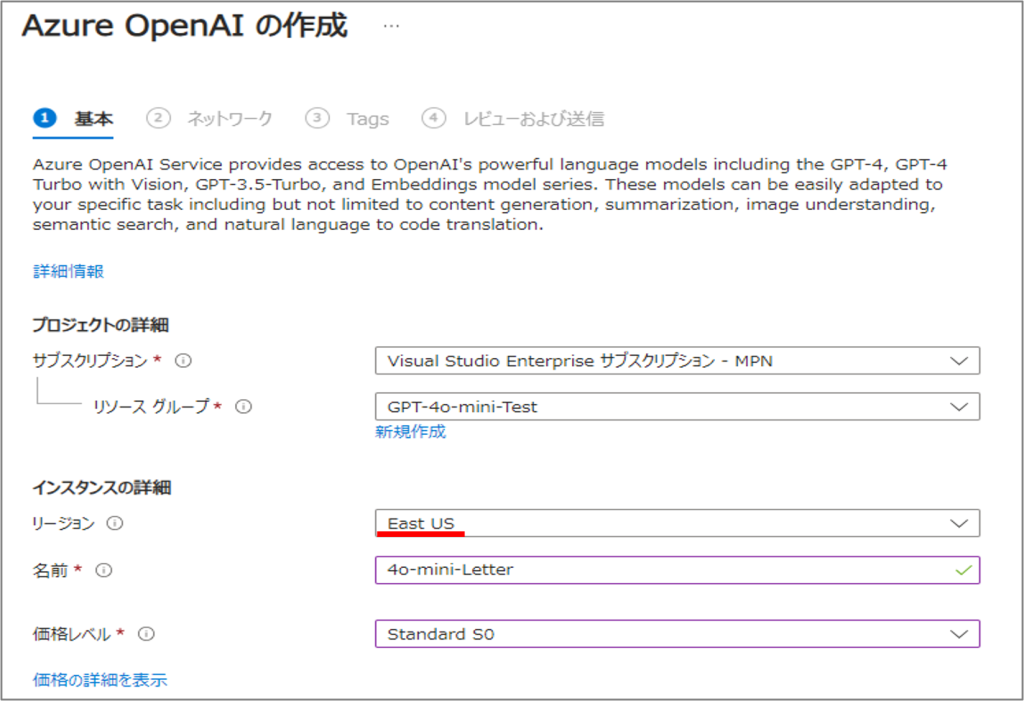

4.リージョン、名前、価格レベルを入力します。

※GPT-4o mini の対応リージョンは現在 East US リージョンのみ です。

5. 作成した Azure OpenAI リソースを選択し、Azure OpenAI Studio に移動します。

6. [チャット] を選択し、[新しいデプロイの作成] を選択します。

7. 必要項目を入力します。モデルは 4o mini を選択します。

8. [チャット] よりプレイグラウンドで 4o mini が使用可能です。

【補足】デプロイ方法

GPT-4o mini では現在以下の2種類のデプロイ方法が利用できます。

(1) Global standard デプロイ

GPT-4o と同時に新たに追加されたデプロイ方法です。対応しているリージョンのいずれかに Azure OpenAI Service リソースが作成されます。ユーザーからのリクエスト時の状況に応じて、動的にルーティングが行われ Global Standard 対応リージョンのいずれかで処理が行われます。

(2) Standard デプロイ

Azure OpenAI Service 公開当初から存在していたデプロイ方法です。Azure OpenAI Service リソースを作成しデプロイを行います。モデルによる処理も同一のリージョンで行われます。

GPT-4o mini でこのデプロイ方法を利用するとコストがわずかに増加します。

入力(100万トークンあたり)⇒$0.165

出力(100万トークンあたり)⇒$0.66

レスポンス比較

GPT-4o mini と GPT-4o で回答速度にどのくらいの差があるか検証してみました。

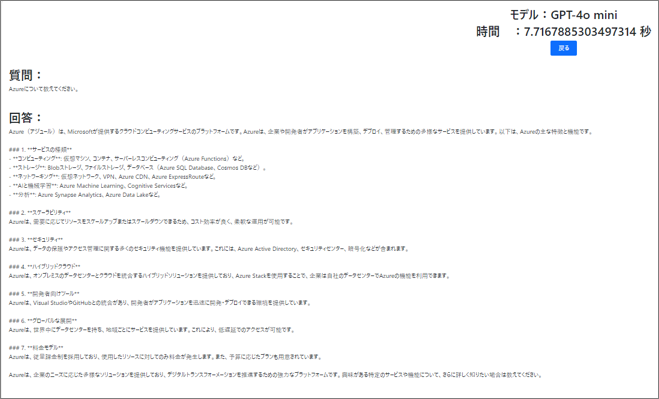

プロンプトは「Azure について教えてください。」とし、それぞれに三回ずつ質問をしてから回答終了までの平均時間を比較します。

| GPT-4o mini | GPT-4o | |

|---|---|---|

| 回答1回目 | 8.39秒 | 17.56秒 |

| 回答2回目 | 6.86秒 | 17.41秒 |

| 回答3回目 | 8.54秒 | 17.23秒 |

| 平均 | 7.93秒 | 17.40秒 |

GPT-4o mini の回答結果

GPT-4o の回答結果

比べてみると、確かに GPT-4o mini が圧倒的に早いですが、回答内容では GPT-4o の方がより詳細に回答を用意してくれているため、文量の差でタイムが伸び縮みしている部分もありそうです。

まとめ

GPT-4o mini の登場は、コストを抑えながらリアルタイムでの応答を求められるシステムやアプリに大きく貢献しそうです。コストの安さや応答の早さを求めるならば GPT-4o mini、より詳細で複雑な作業が必要な場合は GPT-4o といった、GPT モデルの二極化が進んでいる印象です。

本記事をきっかけに GPT-4o mini を試していただき、触れていただけたら嬉しく思います。

Azure OpenAI や GPT に限らず、Azure を使用してわからない部分、「こんなことできる?」などの思い付きがありましたら、是非お気軽にお問い合わせいただければ幸いです。